AIでヒットソングは作れるのか「AIが音楽を変える日」連載第4回

「なんでこんなに色々知ってるのですか?」と拙著を読んだ方から尋ねられることがある。確かに資料の海を漁ってストーリーを紡ぐ作風でやってきたのだが「いや、書くまで知らなかったことばかりですよ」と正直に答えることにしている。

ただ、工夫があるとすれば、テーマを見出したらまず英語で検索ワードの組み合わせをいくつか考える。そこからグーグル・ニュースで出てきた記事は片っ端から読む。PDFも読む。グーグル・ブックス検索でヒットした本を取り寄せて読む。

最近はAIが文字起こしをやってくれるので、リスニングが少々苦手なじぶんでも動画やポッドキャストも資料にしやすくなった。考えてみればグーグル検索も背後でAIが動いているので、私の執筆にAIは欠かせないものになっているのだろう。

それで昨日、偶々出会ったポッドキャストで非常に面白い番組があった。BTSやメアリー・J・ブライジなどを手掛けたサウンド・プロデューサーのイアン・キンメルと、ソングライターで人気ポッドキャスターのチャーリー・ハーディングが「AIだけでTOP40品質のポップソングを創れるか実験してみた」という番組だ。

実際に使ったAIをいろいろ紹介しながら音で制作過程を聴かせてくれるので、とてもリアリティがあった。

まずふたりはChatGPTにどんなテーマを投げてやればまともな作詞をしてくれるのか、試行錯誤した。結局、「この世界で存在しようとあがくインポスター症候群のAI」というテーマで、舞台はNYの高層ビルに設定してプロンプトした。

生成されたのは「目が覚めるとそこは明るい世界 でも下では街の灯が影をつくっていて あなたは高く舞い上がるけど 私は見えない鎖で 地面に縛りつけられている」という歌詞だった。

まず「目が覚めると(Woke up)」という歌い出しが常套句で今のTOP40には向かない。曖昧なのもいただけないので、ふたりはアプローチを変えた。「インポスター症候群に関する10の動詞と、NYの特定の場所に関する10の名詞を組み合わせて」と命令し直したのだ。

すると「忍び寄る摩天楼、砕け散る街の灯、荒れたニューススタンド」等々、なかなかよい言葉が出てきた。「じゃあ、それで作詞して」とプロンプトすると「忍び寄る摩天楼が 夜空とじぶんの影を突き刺すなか 僕らは光を探す 地下鉄に忍び込み 悲鳴の木霊を照らす光を 僕らは別々の列で メトロを待っていた」という歌詞が生成された。まだ抽象的な気がする。

「もっと具体的な場所で」と頼むと「忍び寄る摩天楼 フラットアイアンビル エンパイアステ―ト・ビル ベゼスダ・テラスのとなり セントラルパークの下 光は地下鉄に忍び込む 僕らはすっかり冷めて 君は歌い出した」とむしろ悪化。歌いにくい。ふたりは先にリストアップした10の動詞をもっと使うようChatGPTに指示した。

完成形はこうだ。「忍び寄る摩天楼 突き刺す夜空 街の灯の下 揺れる影 地下鉄に 忍び込む光 聞こえない 悲鳴が木霊して 別々の列で 僕らはメトロを待っていた」残りは省略するが、サビも「I’m walking streets, where I don’t belong, I don’t belong, I’m alone. You broke me up」とサビらしい歌詞が出来た。

ここからは音作りだ。

SUNOという音楽生成AIで、歌詞・ボーカル込で楽曲を生成。もっさりして売り物からほど遠いトラックだった。我々素人だとここで作業終了だが、そこはプロだ。ノキアの着信音風の効果音がスパイスになっているのは気に入ったので、効果音とボーカルをオーディオシェイクAI(audioshake.ai)で抜き出しておく。

さらにSUNOで別バージョンを生成したら今度はダサいカントリー風の曲が出来たが、磨けば使えそうなリフが混ざっていたので、これもAIで抜き出しておく。

この段階でハーディングは頭を抱えたという。このままでは「製薬会社のCMで使われるチープなBGMみたいなものができそう」だったからだ。だが諦めない。このままではTOP40のヴァイブからほど遠いので、サウンドフル(Soundful)という別のAIでエレクトロ風のトラックも生成。いかにもテンプレなアレンジだったが、使えそうなピアノ・リフが混じっていたので、これもAIで分離しておく。

今度はスプライス(Splice)というオンラインのサンプル音源ライブラリにある機能を使って別のアレンジを探すが、やはりそのままでは使い物にならない。だが繰り返すうちに使えそうなドラムの音が入ったチョップ(一小節分のトラック)が出来たので、やはりオーディオシェイクで抜き出しておく。さらにアーケード(Arcade)というソフトウェア・サンプラーについている、演奏パターンを提案してくれる機能を使って別のチョップを作り、ベースの音を抜き出す(こんな面倒な作業はふつう不要だがこれは実験だ)。

ここで人の手が入る。先のピアノ・リフを3つのVSTに通し、今風のリフに変える。これでトラックの核が出来た。これにノキアの着信音風の効果音を重ね、リフのリズムに合わせて先のドラムとベースを足してリズムパートが出来上がる。

そしてベースラインに対応するシンセ・リフを先のアーケードで生成。素材が全て揃ったので、合成してTOP40感のあるテクスチャがようやく出来上がったが、声がハマってない。ヴォイススワップ(voiceswap.ai)のAIで別の声質に差し替え、さらにオートチューン(AutoTune)をかけてEDM風にする。

ちょっとしたオカズも載せたくなった。グーグルのマジェンタ(Magenta)にMIDIデータを投げてリズムパターンを生成。これをベイビーオーディオ(Baby Audio)社のVSTでテープ録音風に変換して出来たパーカッションパートをトラックに追加。このVSTはAIにテープ録音の音を学習させて出来たものだ。

仕上げだ。アイゾトープ社(iZotope)のニュートロン(Neutron)というAIでミキシングし、オゾン(Ozone)というAIでマスタリングして完成。曲はユーチューブで「Can AI make a hit song?」と検索して、34分24秒あたりから再生(https://youtu.be/NCmuITo5iVg?si=RQFqgO6XMfiiQoeN&t=2063)すると聴ける。ポッドキャストの一部なので、遡って21分23秒あたりから聴く(https://youtu.be/NCmuITo5iVg?si=9VF2978-rvWmRc9Y)と初めに生成したトラックがどんどん磨き上げられていく過程を楽しめる。

「評価はリスナーに委ねたい。まだ使いこなすには時間がかかる。でも楽しかった」というのがキンメルの感想だ。最後に種明かしをするが、メロディラインだけはAIのみではプロ品質に到達しなかったので、人力で整え直したそうだ。なんだか分かる気がする。

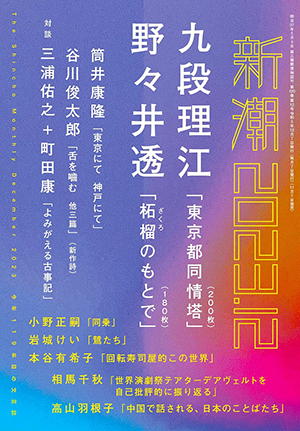

※「AIが音楽を変える日」は現在「新潮」(本日11月7日に最新号発売)にて連載中。Musicmanでは1月遅れで同連載を掲載していきます。

『新潮』2023年12月号(新潮社)

著者プロフィール

榎本幹朗(えのもと・みきろう)

榎本幹朗(えのもと・みきろう)

1974年東京生。作家・音楽産業を専門とするコンサルタント。上智大学に在学中から仕事を始め、草創期のライヴ・ストリーミング番組のディレクターとなる。ぴあに転職後、音楽配信の専門家として独立。2017年まで京都精華大学講師。寄稿先はWIRED、文藝春秋、週刊ダイヤモンド、プレジデントなど。朝日新聞、ブルームバーグに取材協力。NHK、テレビ朝日、日本テレビにゲスト出演。現在『新潮』にて「AIが音楽を変える日」を連載中。

広告・取材掲載