AIがアーティストになる日「AIと人がコラボする日」連載第11回

「それで生成AIって実際に使えるの?」

私の場合、気づけばかなり仕事に使っている。インタビュー記事なら文字起こしをまずNottaというAIにやってもらう。

専門用語や固有名詞は正しく変換されないし、人は話しながら次に言うことを考えるのでそのまま文字にすると文法がおかしかったり、内容の重複があって売り物にならないのだが、それでも文字になっていたら「ああ、こんなことを話していたな」と目で瞬時に追えるので、耳とは違い作業が相当楽になる。

英語でインタビューしたときなどは、全部聞き取れなくても「あとで文章を見ればいいや」と安心できたので議論に集中できて非常に助かった。

この場合も、やはり話し言葉を自動翻訳したらめちゃくちゃで使えないが、翻訳はじぶんでやればいい。原稿が出来上がって、フランスのクライアントとやり取りしたときには、自動翻訳もすばらしい力を発揮してくれた。プロユースに仕上げたしっかりとした文章なら、DeepLはそれなりの翻訳をしてくれる。

執筆の打ち合わせの議事録も生成AIを立ち上げておけば勝手にまとめまで作ってくれて、アクション・リストまで添えてくれた。ChatGPTの登場が世を騒がせて二年半でこれだから末恐ろしい。

ただ、ChatGPTが執筆の調べ物で役に立ったことは一度もない。ネットの意見の平均値をまとめたものを返されても売り物の素材にはならない。今、試しにそれを逆手に取って「音楽とAIについて、コラムに出来るテーマをリストして」と入れてみたらきれいにまとめたものを返してきた。少なくとも世の需要はよく分かった。AIも人間も、ものは頼みようらしい。

ここまで書いたのは「それで生成AIってプロの音楽制作で使えるの?」という問いに、「文章での経験上、全部を丸投げするのでなければあり得るんじゃないか」と薄々感じていたからだ。

「AIでヒットソングは作れるのか」の回では、簡易マスタリングやトラックの抽出、声の差し替えなどで、生成AIがプロの現場で既に使用されている様を紹介した。最近では、仮歌でも積極的に利用されている。Synthesyser VというボーカロイドのAI版のようなソフトがそれだ。

だが、みんなが知りたいのはそういう部分的な利用ではなく、「テキスト・プロンプトで生成した楽曲はプロの品質になりうるのか?」ということだろう。無数に生成された楽曲を聞く限り、ちょっと無理そうと感じても仕方がない。

ただ、それはAIに丸投げしようとするから無理なのではないか。AIを人間とコラボできるサポート役に作り変えたらどうだろうか?

グーグルはまず作詞でそれをやった。「AIがライムを刻む日」で紹介したTextFXがそれだ。歌詞すべてを生成する開発方針を捨て、人気ラッパーのルーペ・フィアスコと共に、リリックを創作するのを助けるツールに仕上げたら十分、プロユースに耐えるものが出来上がった。それが昨年の夏だ。

ということは、同じ開発方針で楽曲の生成AIを作り変えたらどうなるのかと思っていたら今年五月、グーグルが開発者向けイベントでまさにそれをリリースしてきた。名をMusic AI Sandboxという。

ユーチューブの公開動画には「音楽の究極のコラボレーター」(The ultimate collaborator in music)と添えられているが、比喩ではなく本当にAIがミュージシャンとコラボしている。一度見てほしい。

TextFXのときと同様、グーグルは今回も大物ヒップホップ・アーティストと協業した。フージーズの元メンバーで累計3000万枚超の売上を誇るワイクリフ・ジョンが一人目だ。動画の冒頭、彼がギターでベースライン風のフレーズを弾き、AIに放り込む。それから「(故郷である)ハイチとブラジルが出会うとどうなる?」と指示すると、ワイクリフが身を乗り出すほど絶妙なテクスチャが生成された。

「俺たちヒップホップのプロデューサ―はいつもネタを探してる。レコードを再生して、ボーカルのないところを切り取ってサンプリングし、それを膨らませて曲を作る」

この〝Sandbox〟を使えば、この作業をヴァーチャルで無限に出来るとワイクリフはいう。デモ動画では他にふたりのアーティストが登場する。

「頭の中で鳴っているものに辿り着くために、ソングライターの言葉でAIツールに語りかけるだけでいいんだ。ワクワクするよ」

そう語るのはレディ・ガガやブリトニー・スピアーズ、アリアナ・グランデなどに曲を提供する売れっ子ソングライター、ジャスティン・トランターだ。

驚くのは彼が「1986年のパリのファッション・ウィークみたいに」とか「汗びっしょりで、砂っぽくて、午前三時の感じで」と、かなり詩的で曖昧な指示を与えているのに、AIがそれに応えてくる様だ。

三人目に登場するエレクトロのDJ、マーク・ラヴィエは二四〇万人のチャンネル登録を持つ人気ユーチューバーでもある。

「ボンゴを試そうか」「それからヴィオラを乗せて」「リズミックな手拍子を入れよう」彼が指示を重ねると、狙っているサウンドに近づいてゆく。

「皮肉な話なんだけど、一日中やってると終わる頃には、いっそう人間っぽい音になっているんだ」

ラヴィエのこの感想は、AIと人間のコラボが何たるか、端的に示している。

「変わった友だちと一緒にやっているみたいな感じだ。『これ試してくれる?あれやってみてよ』っていうと『OK。わかった』って感じでね」

音楽の生成AIはこれまで素人でも音楽を作れることが最大の売りだった。それは誰でも曲を作る楽しみを味わえるようにした「音楽制作の民主化」でもあったが、機械的に楽曲を無限に生成できるということは、裏を返せば、音楽を無機的なものにする恐怖を我々に与えていた。人間には理解しがたい不気味な響きがあることもそれを助長した。

一方でグーグルの〝Sandbox〟はプロユースを念頭において開発されている。しかも操作は素人でも使えるくらい簡単なままだ。違いは、心に浮かんだイメージを求めて指示を与えるほどに、生成物をますます人間らしくしていけることだ。それがプロユースの本質だとしたら、大げさかもしれないが、人類の今後にとっても示唆的ではないか。

無機質な岩の塊に鑿を重ねて彫刻に命を吹き込んでゆくロダンの姿が、AIと人間の将来であるなら、私は見てみたい。

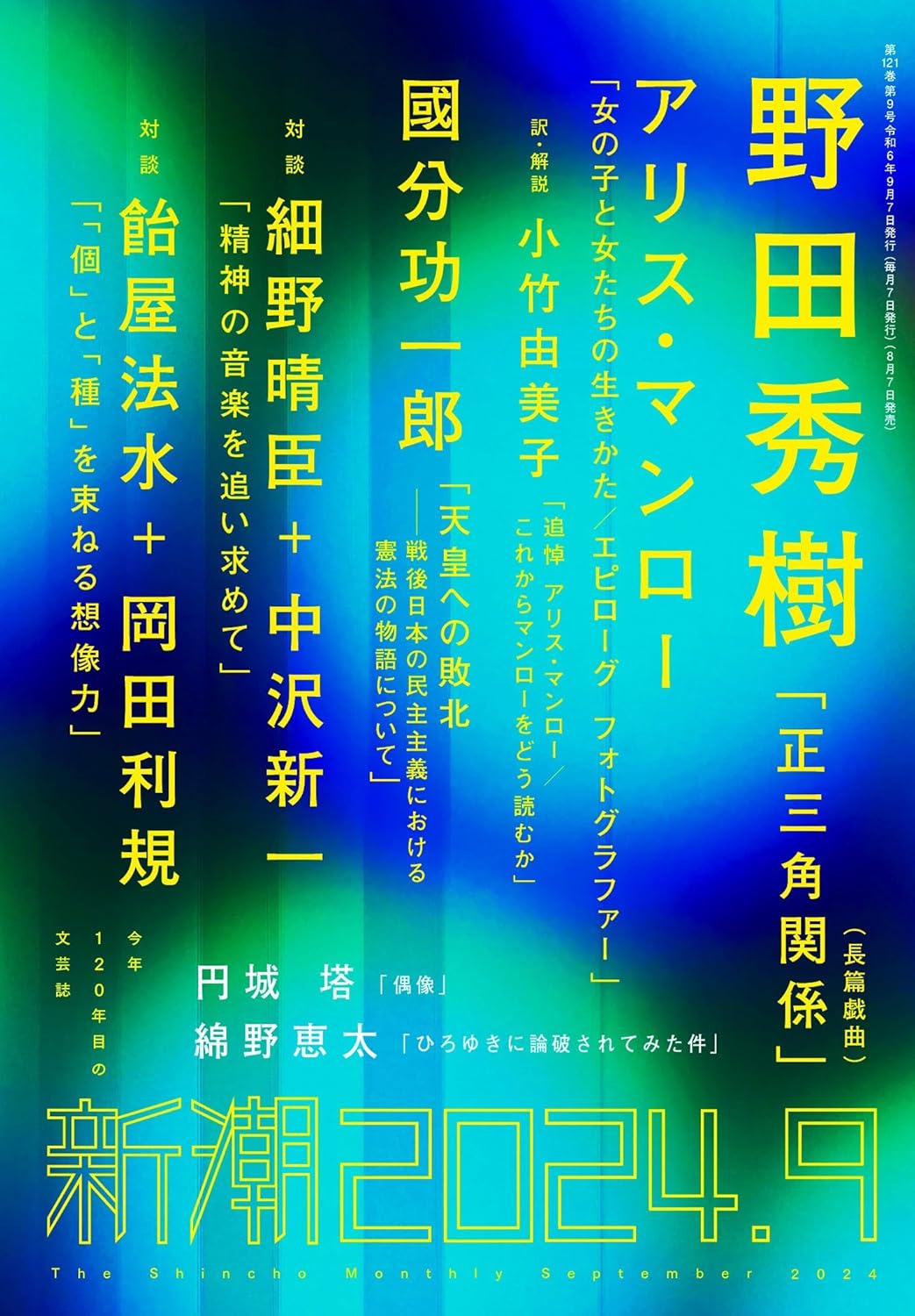

※「AIが音楽を変える日」は現在「新潮」(8月5日に最新号発売)にて連載中。最新回は新潮でお読みいただけます。

『新潮』2024年9月号(新潮社)

著者プロフィール

榎本幹朗(えのもと・みきろう)

榎本幹朗(えのもと・みきろう)

1974年東京生。Musicman編集長。作家・音楽産業を専門とするコンサルタント。上智大学に在学中から仕事を始め、草創期のライヴ・ストリーミング番組のディレクターとなる。ぴあに転職後、音楽配信の専門家として独立。2017年まで京都精華大学講師。寄稿先はWIRED、文藝春秋、週刊ダイヤモンド、プレジデントなど。朝日新聞、ブルームバーグに取材協力。NHK、テレビ朝日、日本テレビにゲスト出演。現在『新潮』にて「AIが音楽を変える日」を連載中。

関連リンク

関連リンクはありません

広告・取材掲載